L'histoire mouvementée de l'intelligence artificielle

Entre avancées majeures et périodes de stagnation, l’histoire de l’IA est une histoire mouvementée, qui a débuté dès la première moitié du 20e siècle.

Entre avancées majeures et périodes de stagnation, l’histoire de l’IA est une histoire mouvementée, qui a débuté dès la première moitié du 20e siècle. Voici les origines de ce concept dont on entend si souvent parler.

Avant la Seconde Guerre mondiale, le concept d’une intelligence robotique émerge peu à peu dans les œuvres de fiction. En 1920, Karel Capek, un écrivain tchécoslovaque, écrit Rossum’s Universal Robots, une pièce de théâtre de science-fiction. C’est dans cette pièce que le mot robot est utilisé pour la première fois, afin de désigner des machines à l’apparence humaine, chargées des corvées. En 1927, ces robots apparaissent pour la première fois sur le petit écran, avec le film Metropolis, réalisé par Fritz Lang.

Si ces idées restent cantonnées à la fiction par manque de moyens technologiques, quelques découvertes – en particulier à partir de la Seconde Guerre mondiale - vont être utiles au développement d’une intelligence robotique. Ainsi, en 1943, les scientifiques McCulloch et Pitts inventent le premier neurone artificiel, ce qui a permis de mettre au point les réseaux neuronaux que nous connaissons aujourd’hui.

L'après-guerre, terreau fertile pour la recherche informatique

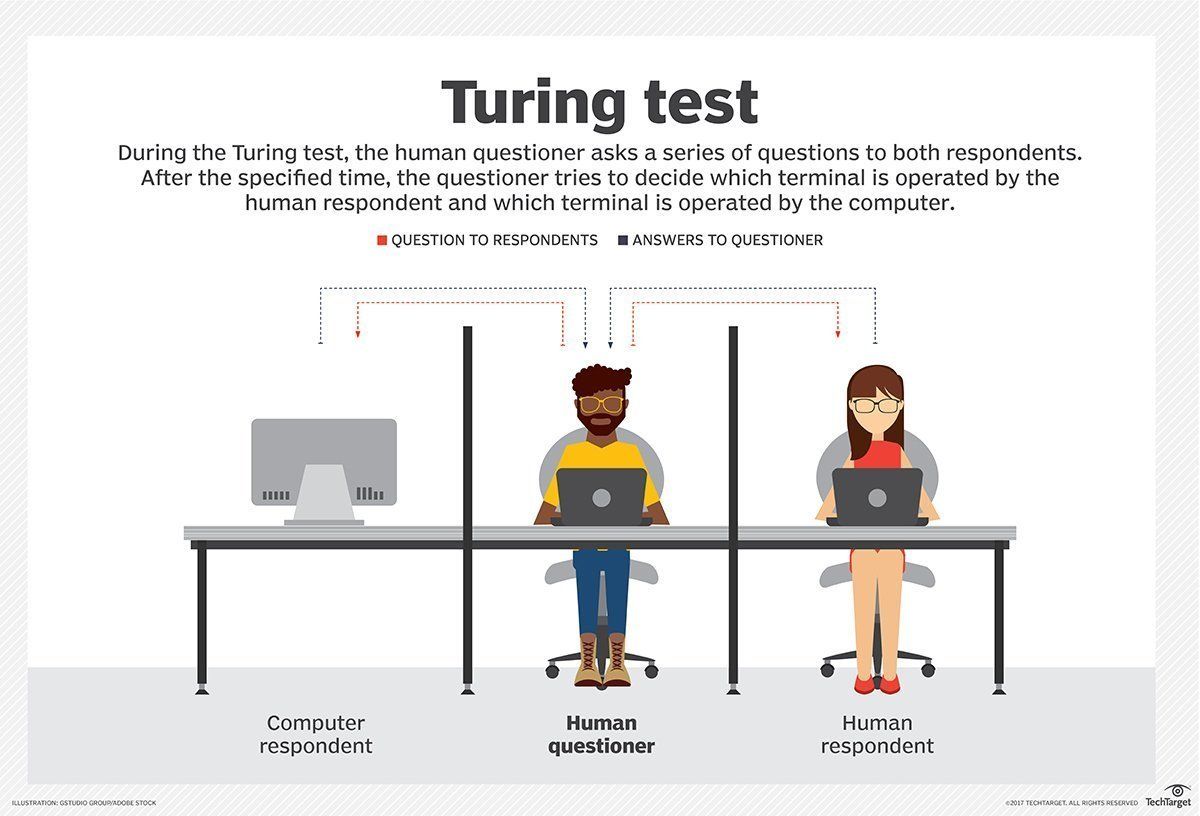

C’est à partir de 1950 que l’on assiste réellement aux prémices des intelligences robotiques. Cette année, Alan Turing, mathématicien connu pour avoir participé au décryptage de la machine Enigma pendant la Seconde Guerre mondiale, met au point le Test de Turing, ou Imitation Game. Présenté dans le magazine scientifique Computing Machinery and Intelligence, ce test a pour objectif de déterminer la faculté d’une machine à imiter une conversation humaine normale, avec des messages textuels. La personne réalisant le test est placée face à la machine et un autre humain, à l’aveugle, et doit déterminer lequel de ses interlocuteurs est un ordinateur. Si elle désigne l’autre personne comme étant un ordinateur, la machine réussit le test. Malgré les faiblesses du test, comme le fait qu’il mesure l’imitation du comportement humain et non l’intelligence, ce dernier a beaucoup été utilisé, et l’est encore dans certaines circonstances.

Maintenant qu’il existe un test d’intelligence pour les machines, il ne manque plus que des programmes imitant une intelligence humaine. Entre 1955 et 1956, les scientifiques Simon, Newell et Shaw créent le premier programme destiné à imiter la capacité humaine à résoudre des problèmes. Intitulé Logic Theorist, ce programme est conçu pour prouver des théorèmes mathématiques issus du Principia Mathematica, un ouvrage de 1910 sur les fondements des mathématiques.

Notez que je n’ai toujours pas évoqué le terme d’intelligence artificielle dans cet article. En effet, cette expression est inventée par John McCarthy lors d’une conférence scientifique organisée à l’été 1956.

John McCarthy, pionnier de l'IA

John McCarthy, né en 1927 à Boston, est un informaticien américain considéré comme l’un des pionniers de l’intelligence artificielle, avec son confrère Marvin Lee Minsky. En plus d’avoir inventé le terme, il est aussi le créateur d’un des langages de programmation les plus utilisés dans ce domaine, le langage LISP. Enfin, il a aidé à populariser l’approche ‘’temps partagé’ en informatique, qui permet de partager une ressource informatique entre différents utilisateurs au même moment. C’est le principe au cœur du cloud.

Les années 1960, théâtre d'avancées majeures

Après les découvertes éparses des années 1950, les années 1960 et le début des années 1970 sont jalonnées d’avancées significatives, et elles signent le début d’une réflexion plus approfondie sur l’intelligence artificielle.

En 1963, le groupe de recherche sur l’IA fondé par Marvin Lee Minsky et John McCarthy est intégré au Projet MAC du MIT (Mathematics and Computation), spécialisé dans la recherche informatique. Le projet , qui fusionnera avec le Laboratory Computer Science en 2003 pour former le fameux MIT Computer Science and Artificial Intelligence Laboratory (CSAIL), est un acteur majeur de l'évolution de l'IA.

Durant cette décennie, plusieurs programmes et automates déterminants pour le futur de la recherche sont également développés. Le plus important est le chatbot ELIZA, un programme interactif créé en 1965 par Joseph Weizenbaum. Capable de converser en anglais, ELIZA est l’un des premiers programmes capables d'être soumis au test de Turing, créé 15 ans plus tôt.

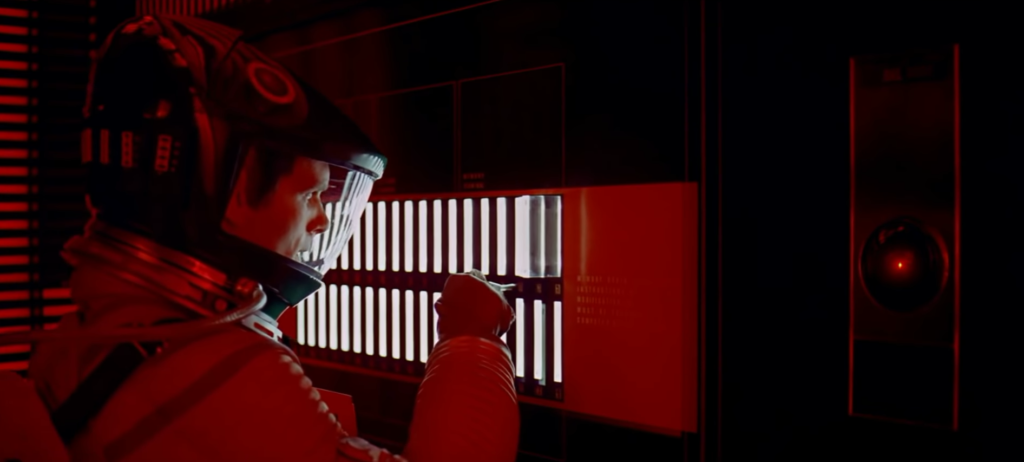

En parallèle, les intelligences artificielles continuent d’intéresser le grand public. En 1968, le film 2001 : L’Odyssée de l’espace, réalisé par Stanley Kubrick, sort en salle. Un des personnages principaux du long-métrage est HAL 9000, une intelligence artificielle capable de discuter, de reconnaître des personnes et des émotions, et de piloter un vaisseau spatial.

Si cela peut sembler révolutionnaire pour l’époque, un grand nombre de scientifiques est alors convaincu qu’un programme avec les capacités d’HAL existerait avant la fin du siècle. Spoiler : ça n’est pas arrivé.

Le ralentissement de la recherche et le premier hiver de l’AI

Plusieurs raisons peuvent expliquer cet échec. En 1973, James Lighthill, un mathématicien britannique, publie une étude d’ensemble sur l’intelligence artificielle. Dans ce rapport, il estime que peu de progrès sont réalisés dans ce domaine, en dépit d’investissements colossaux, car les scientifiques rencontrent plusieurs difficultés techniques qui brident leurs progrès. Les attentes élevées des investisseurs vis-à-vis de la recherche en IA ne sont pas satisfaites.

Au même moment, la DARPA, l’agence américaine pour les projets de recherche avancée de défense, décide de réduire les fonds alloués à la recherche théorique en intelligence artificielle.

Avec la publication du rapport Lighthill et la chute des investissements, la première bulle de l’intelligence artificielle éclate, et initie le premier hiver de l’IA (AI winter en anglais). Durant cette période, peu d’avancées sont réalisées. Les années 1970s sont donc très calmes sur le plan de la recherche en IA.

Les années 1980 : des progrès significatifs, stoppés nets en 1987

Il faudra attendre les années 1980 pour voir de nouvelles avancées dans la recherche en intelligence artificielle. Cette reprise est timide, et les conséquences de l’hiver de l’IA sont toujours présentes. Cependant, cette période n’en est pas moins importante : entre réseaux de neurones et voitures autonome, elle joue un rôle déterminant dans l’histoire de l’IA.

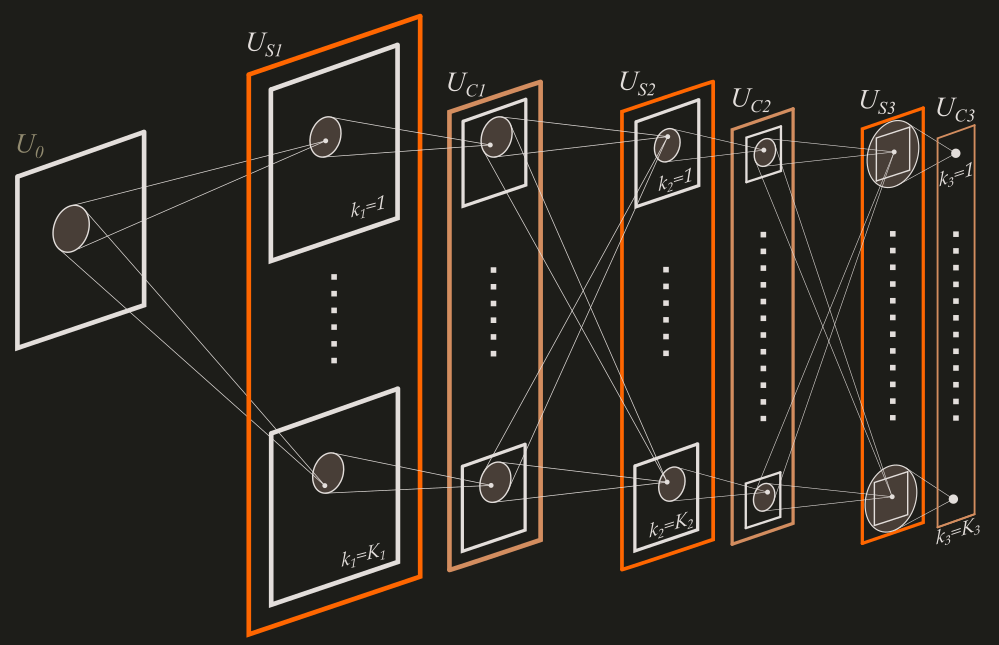

En 1980, l’informaticien japonais Kunihiko Fukushima développe le Neocognitron, un réseau de neurones à plusieurs couches inspiré par le cerveau des animaux. Il est l’ancêtre des réseaux de neurones convolutifs, qui sont à ce jour les plus performants en termes de classification d’images.

Les années 1980 marquent aussi le début de la recherche sur les voitures autonomes. En 1986, deux modèles de voiture autonomes sont conçues en parallèle par l’université Carnegie Mellon (avec le projet Navlab, financé par la Darpa), et par Mercedez-Benz (avec le projet VaMoRS).

Cependant, ces progrès ne redorent pas entièrement le blason de l’IA. Dès 1984, l’Association pour le Progrès de l’Intelligence Artificielle (Association for the Advancement of Artificial Intelligence) met en garde les scientifiques du fait qu’un nouvel hiver de l’IA est possible. Trois ans plus tard, leurs dires seront confirmés.

En effet, en 1987, le marché des machines ‘’LISP’’ - fonctionnant grâce au langage du même nom inventé par John McCarthy – s’effondre. Considérées comme trop fermées et pas assez efficaces, ces machines fondées sur l’intelligence artificielle se font rapidement dépasser par les ordinateurs personnels d’Apple et d’IBM, plus performants et moins chers.

S’il est normal que ces machines obsolètes disparaissent, ce crash est aussi le signe d’un scepticisme toujours présent envers l’intelligence artificielle. En parallèle de la disparition des machines LISP, les systèmes experts, très populaires dans les années 1980, perdent en popularité à cause de leurs nombreuses limitations.

Qu'est-ce qu'un système expert ?

Un système expert est un logiciel capable de répondre à des questions, en effectuant un raisonnement à partir de faits et de règles connues. Il se divise en deux parties : une base de données, qui contient des faits et des règles, et un moteur d’inférence, qui se sert des données pour produire de nouveaux faits.

Voitures autonomes, chatbots et jeux d'échecs : l'IA dans les années 1990

Le début des années 1990 est, à l’image de la fin des années 1970, très calme. Conséquence logique du deuxième hiver de l’IA, ce contexte n’empêche cependant pas certains chercheurs de continuer leurs recherches.

En 1995, l’informaticien Richard Wallace dévoile le chatbot A.L.I.C.E. (Artificial Linguistic Internet Computer Entity). Inspiré par ELIZA, ce nouveau programme est très performant dans l’interprétation des questions posées, et est capable de contourner les questions quand il ne les comprend pas. Grâce à ces fonctionnalités, A.L.I.C.E est élu meilleur chatterbot en 2000, 2001 et 2004.

Les progrès ne se limitent pas à des chatbots. En 1997, après plus d’une dizaine d’années de développement et une défaite en 1996, le superordinateur Deep Blue bat le champion du monde d’échecs Garry Kasparov. Cette victoire, qui fait la une des médias, est un tournant majeur : pour la première fois, un ordinateur bat un humain dans un jeu complexe, qui ne demande pas uniquement de la puissance de calcul.

Les années 2000 et les robots, une histoire d'amour

Avec le passage au nouveau millénaire, le rythme de développements de nouvelles technologies liées à l’IA s'accélère. C’est également à cette période que la technologie commence à être accessible au public.

Tout d'abord, la décennie 2000-2010 est particulièrement riche en termes de conception de robots. En l’an 2000, une scientifique du MIT développe Kismet, un robot capable de reconnaître et d’imiter des émotions. La même année, Honda sort ASIMO, un robot de recherche humanoïde doté d’une intelligence artificielle.

C’est aussi à cette période que les intelligences artificielles commencent à nouveau à attirer du public sur le grand écran. A.I. Artificial Intelligence et I, Robot, sortis respectivement en 2001 et en 2004, en sont deux exemples. Le premier, réalisé par Spielberg, raconte l’histoire d’un enfant-robot humanoïde capable d’éprouver des émotions, tandis que le second parle d’un monde où les robots sont partout, et servent d’auxiliaires aux humains.

Les années 2010 : un nouvel âge d’or de l’IA ?

La démocratisation de l’IA se poursuit à partir de 2010. Pendant cette décennie (que nous venons d'ailleurs tout juste de quitter), des avancées significatives ont été réalisées dans tous les domaines, liés de près ou de loin à l’intelligence artificielle.

En dignes successeurs de Deepblue, certains programmes ont marqué l’histoire en gagnant des jeux plus complexes que les échecs. En 2011, le super-ordinateur IBM Watson réussit à battre les champions du jeu américain Jeopardy, qui consiste à deviner les questions en fonction des réponses. En 2019, Google se distingue également en développant Alphastar, un programme capable de battre des joueurs professionnels de StarCraft II.

Starcraft II, un jeu réputé pour sa complexité

Starcraft II est un jeu de stratégie en temps réel où le but est de vaincre l’adversaire en contrôlant plusieurs centaines d’unités en même temps. Selon David Silver, un scientifique de l’équipe d’Alphastar, il y a 1026 choix possibles pour chaque mouvement, ce qui rend la victoire beaucoup plus complexe qu’au jeu de Go. De plus, les joueurs n’ont pas toutes les informations sur le joueur adverse à leur disposition.

Cette période historique a aussi vu se démocratiser les assistants virtuels comme Siri, Google Home, et Alexa, mais également les véhicules autonomes ou la reconnaissance faciale. Avec l'implication massive des GAFAM (Google, Amazon, Facebook, Apple, Microsoft) et les investissements colossaux, la recherche n'a jamais été aussi soutenue.

Aujourd'hui, l’IA est partout, et elle est en passe de révolutionner notre manière de vivre et de travailler.

L'IA peut changer nos vies, pour le meilleur comme pour le pire. En effet, le fait qu'elle soit si facilement accessible peut aussi mener à des abus. Certaines technologies, comme les deepfakes et la reconnaissance faciale, posent des problèmes éthiques : entre les mains de gouvernements autoritaires ou d’entreprises peu scrupuleuses, la liberté et la vie privée peuvent vite être menacés.

Pour en savoir plus sur les enjeux éthiques de la reconnaissance faciale, n’hésitez pas à aller lire l’article sur le sujet.

Antoine F.

Sources

- A History of Artificial Intelligence, S. Hussain Ather

- A Complete History of Artificial Intelligence, Rebecca Reynoso (G2 Learning Hub, 2019)